最近「サイト改善にどのAIが一番使えますか?」と聞かれる機会が増えてきました。

ChatGPTをはじめ、ClaudeやGemini、Copilotなどいろんな会話型AIがあり、さらにアクセス解析や行動データを自動で読み解いてくれる「分析特化AI」、いわゆるAIアシスタント機能を持っているツールもあります。

ただ、実際にAIを使ってサイト分析や改善ポイントのアイデアを出してもらうと「どれも万能!」というわけではありません。

AIごとに得意・不得意があって、数値は強いけどコピー改善は苦手、逆にアイデアは出せるけど数字の根拠は弱い…そんな違いが見えてきます。

先日みなさんにお送りした丸山のメルマガでも、「どのAIが良いのか?」をテーマに話しています。(こちらはサイト改善に限った話ではないのですが…)

丸山とよく雑談で話していることなのですが、今回は、実際にいろんなAIを試してみた体験から「サイト改善」という観点でそれぞれのAIの特徴をまとめてみました。

目次

会話型AIを比較してみた(サイト改善)

完全に主観ですが、会話型AIにデータやサイトを読ませて、サイト改善アイデア出しをしてもらったときの比較をしてみます。

ChatGPT(OpenAI)

一番よく使うのはChatGPTです。

「このフォームの説明を柔らかくしたい」と相談すれば、3案くらいコピーを返してくれます。

CTA文言や記事タイトルのアイデア出しなど、発想の壁を突破する瞬発力は抜群です。

ただし「どのページから直すべき?」といった数字ベースの判断は苦手で、やや一般論に寄りがちだなぁと感じます。

Claude(Anthropic)

Claudeはロジカルで落ち着いた文章力に強みがあり、長文を整理するなら一番安心感があります。

GA4のレポートをそのまま突っ込んでも、すっきり要約して改善方針をまとめてくれます。そのためクライアントや上司に渡すレポートを作る場面ではすごく助かるなーと思います。

一方で、コピーやキャッチーなアイデアは一般的でちょっとイマイチです。

Gemini(Google)

Google製なので、やっぱりGAやSearch Consoleとの親和性が魅力です。

検索トレンドや競合状況を踏まえて「このテーマを強化すると良い」と提案してくれます。SEOの方向性を考えるには重宝しています。

ただ、日本語の自然さやキャッチコピー生成はまだ弱めで、マーケティング文脈では物足りないと感じることもあるので、GeminiのアイデアをChatGPTに投げて相談することも多々あります。

Copilot(Microsoft)

ExcelやPowerPointとの組み合わせで真価を発揮します。

「離脱率の高いページは?」とExcelに聞くと、グラフ化+コメントまで自動で出してくれます。Microsoft365を社内で多く使っている場合、Copilotを活用することで社内共有のスピードが圧倒的に速くなります。

どちらかというとCopilotは「業務効率化のためのAI」という印象です。

独自のアイデアや柔らかい文章はあまり得意ではなく、補助的な役割にとどまる感じです。

読ませるデータとプロンプトが大事

会話型AIをサイト改善で使っているとき一番実感するのは、「どんなデータを読ませるか」で答えの質が変わるということ。

例えばGA4のダッシュボードをそのまま貼って質問しても、AIはあいまいな「それは分かってる」というコメントしか返してくれません。

でも生データや具体的な数字を渡すと、「このページからの離脱率が高いので、CTAの位置を見直すと効果的です」と具体的に返してくれます。

さらにプロンプト(指示の出し方)も超重要です。

「サイトを改善するには?」とざっくり聞くと一般論しか返ってきません。

でも「直帰率が高いページの改善施策を、UXとSEO両方の観点から教えて」と条件を加えると、だいぶ実務的な提案になります。

AIに正しい材料を渡して、的確に質問すること。

これができないと「便利そうだけど使えない」と感じてしまいます。

同じデータとプロンプトをそれぞれAIに投げてみた

QA ZEROは今秋AIアシスタント機能を強化します。AIレポートでは、AIに投げるためのデータ整理とプロンプトを生成してくれます。

この機能を利用して、同じデータとプロンプトをそれぞれAIに投げてみました。

渡したデータはSEOの分析データであり、サイトの目的は「BtoBの問い合わせを増やすこと」であることもプロンプトで伝えています。

長い回答がそれぞれのAIからは返ってきていますが、「総括アドバイス」の内容のみを比較します。

ChatGPT(OpenAI)

まず着手すべきこと(順番)

- 上位3記事に“統一導線”を実装(FV固定CTA/目次下3連リンク/章末ミニCTA)。

- GSCで順位8〜12位のクエリに合わせてタイトル・見出しを微調整(検索意図の言い換え語を反映)。

- カニバリの主役URLを決めて集約(ルートURLに内部リンク集中、補助記事は差別化)。

期待できる変化

- 2ページ到達率が先に改善し、直帰率が低下。その後、該当クエリのCTR・順位がじわり改善(タイトル最適化+内部リンク集中の相乗効果)。

- /lineup/ への遷移が増加し、事例・価格ページの閲覧→問い合わせへの導線が太くなります。

参照すべきワークシートと見方

- 02_SEOランディング:セッション多い順に並べ、到達率が低いのに滞在がある記事=優先改善候補。

- 01_GSC_クエリ分析:順位8〜12位×CTR低めのクエリに絞り、タイトル・見出しの用語(とは/使い方/設定方法 等)を合わせ込む。

- 05_2ページ到達率:高到達記事のレイアウト(目次下リンク・章末リンク位置)をテンプレ化して横展開。

- 03_高直帰SEO:高直帰の5本に、まず冒頭CTA+章末ミニCTAを差し込んで効果測定。

- 04_長時間滞在SEO:180秒超の9本に機能/事例リンクを差し込んで“読み切り→次アクション”へ。

Claude(Anthropic)

まず着手すべきこと

- 最優先は主要流入ページ(月223セッション)の記事末尾に関連記事セクションを追加することです。この1つの改善で月間50-70件程度の追加ページビューが期待でき、最終的に月2-3件の問い合わせ増加につながる可能性があります。

- 次に、検索順位9-10位の「code interpreter」関連キーワードのタイトルとメタ説明を最適化し、検索結果1ページ目を狙います。順位が5位以内に入れば流入が2-3倍になり、月間セッション数を800-900程度まで押し上げられます。

詳細分析用ワークシート活用方法

- 02_SEOランディング: 各記事の滞在時間と直帰率を照らし合わせ、改善優先度を判断する際に使用

- 05_2ページ到達率: 内部リンク施策の効果測定に使用し、施策前後の数値変化を追跡

- 01_GSC_クエリ分析: 月次でクリック率と順位の変化を確認し、SEO施策の成果を測定

Gemini(Google)

まず着手すべきこと

- まず何から着手すべきかというと、最も優先すべきは「既存記事の改善」です。

- せっかく多くのユーザーがアクセスし、記事をじっくり読んでくれているのに、その後の行動につながっていないのは非常にもったいない状態です。この記事のポテンシャルを最大限に引き出すため、回遊を促す施策にまずは着手しましょう。

- 具体的には、「B: やること(回遊を増やす具体策)」で挙げた施策を、特にセッション数が多い上位3つの記事から順番に試してみてください。これらの施策は、ウェブサイトの見た目を大きく変える必要がなく、小さな修正で始められるものが多いです。

- これらの施策によって期待できる変化は、直帰率の改善と2ページ到達率の向上です。今まで記事を読んで離脱していたユーザーが、次に「サービスページ」や「導入事例」を見てくれるようになります。これが、最終的な問い合わせ件数の増加につながります。

より詳しく分析を進めたい場合は、以下の表を活用してください。

- 「02_SEOランディング」と「04_長時間滞在SEO」:これらの表から、ユーザーが興味を持っているコンテンツを特定し、その記事に回遊施策を優先的に組み込んでいきましょう。

- 「05_2ページ到達率」:この表からは、すでに回遊に成功している記事の共通点を分析できます。成功事例を他の記事にも応用することで、効率的にサイト全体の改善を進められます。

Copilot(Microsoft)

まず着手すべきこと

- 回遊率の低い記事に「次の行動」への導線(事例・価格・相談)を追加することが最優先です。

期待できる変化

- 直帰率の改善と、2ページ到達率の向上により、問い合わせへの導線が強化されます。

詳しく見たい場合の表の使い方

- 「02_SEOランディング」:滞在時間や直帰率を確認し、どの記事が読まれているかを把握

- 「05_2ページ到達率」:回遊に成功している記事を参考に、他記事への応用を検討

- 「01_GSC_クエリ分析」:検索結果での表示とクリックの差を見て、タイトル改善のヒントに

これから広がるMCPの話

最近、MCP(Model Context Protocol)がAIとデータ接続の “橋渡し役” として急速に注目を浴びています。

GA4とMCPの連携がすでに使えるようになってきており、AI 活用の現場に大きな変化をもたらしつつあります。

今MCP × GA4でできること

Googleは、GA4用のMCPサーバーを提供しており、AIとGA4のデータを直接つなぐことが可能になっています。

たとえば、AI に「先月の上位流入チャネルを国別で出して」「直帰率が高いページを教えて」などと問いかけると、MCP経由で GA4データを参照して答えを返すことができます。

ただしAIの特性として、数値計算を確率論で解いてしまうため集計値を間違えたり、また現状は、読み取り専用が基本で、GA4設定を変更したり、タグ設定を操作したりという書き込み操作までは許可されていません。

また、MCPサーバー設定はPC側のPythonやNode.jsなどの知識が必要だったり、Google 側 API(Analytics Data API, Admin API など)の設定や認証も必要なため、導入ハードルは若干高い印象です。

今後どうなる?

MCPは「AIと複数の外部ツール/データソースをつなぐ標準化レイヤー」なので、GA4においては、GA4 以外のデータ(CRM、広告配信ログ、ERP、顧客DBなど)との統合も視野に入ってきます。

このままAIが進化すれば、複数のデータソースを横断的に参照しながら改善案を立てられる世界が来ると私たちは考えています。

たとえば「広告の費用対効果を GA4 データと広告出稿データを横断して判断 → じゃあどの流入チャネルを強化するか提案」という流れが人の手を借りず AI 主導で起きるようになるかもしれません。

今までは「人がレポートを集めてAIに渡す」必要がありましたが、MCPが広がるとAIが勝手にデータを取りに行って改善案を提示する未来が近いかもしれません。

その分、人間は「どの施策を優先するか」「実際に実行するかどうか」の判断に集中できます。

これ、かなり大きな変化ですよね?

そして、QA ZEROのAI連携は「MCPの先を見据えて」進めています。

私たちが意識しているのは「AIを活用した時に、間違った判断や問題が発生しづらい仕組みにする」こと。

AIと人が協力し、創造的に楽しく問題解決にあたれる未来を目指し、さまざまなAI機能を実装しています。

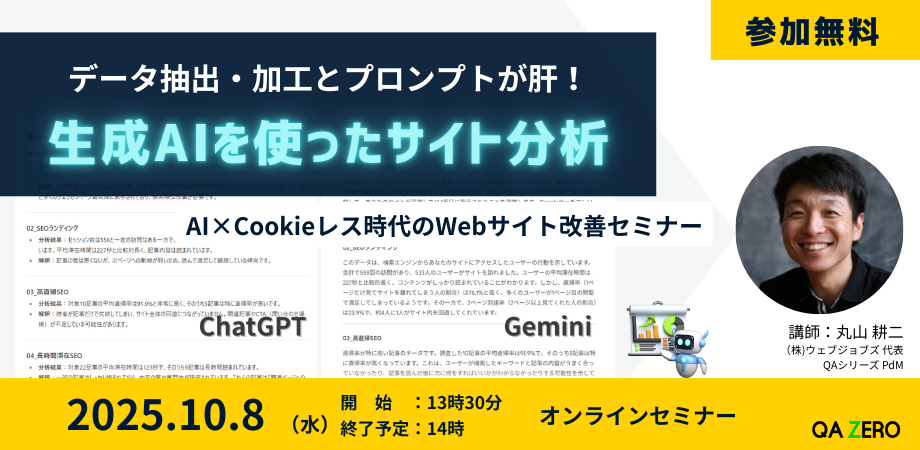

【無料オンラインセミナー開催】生成AIを使ったサイト分析 -データ抽出・加工とプロンプトが肝!

- GA4の数値を見ていても、どこに問題があって何を改善すべきかが分からない

- 上司やクライアントに毎月報告するサイト分析レポートの作成、意外と時間がかかる

- 生成AIを使ってサイト分析、ってよく見るけど、あまり役に立つ回答がAIから返ってこない

こんなお悩みはありませんか?

- 同じプロンプトを投げてサイト分析した比較(ChatGPT, Gemini, Claude, copilot)

- プロンプト例

- どんなデータを渡せば生成AIは正しくサイト分析をしてくれるか

など、生成AIを使ったサイト分析の方法についてお伝えします。

みなさまのご参加お待ちしております!